L’évaluation des laboratoires et équipes de recherche. Un sujet de débat souvent passionnel et une source inépuisable d’irritation dans notre communauté. Je vous propose de regarder ensemble quelques données objectives (comme d’habitude) et aussi de vous faire part de réflexions et propositions personnelles subjectives que j’en tire.

Le HCERES (Haut Conseil à l’Évaluation de la Recherche et de l’Enseignement Supérieur) vient de se voir doté d’un nouveau président dont on peut imaginer qu’il voudra imprimer son style et ses idées sur le processus d’évaluation (je ne porterai pas de jugement sur la personne ou le processus de sa nomination dans ce billet, ce n’est pas l’objet). C’est donc un moment opportun pour mettre son nez dans le sujet compliqué et souvent pas complètement consensuel qu’est l’évaluation des laboratoires de recherche (litote…).

Ma carrière académique étant plutôt derrière moi que devant, je pense bénéficier d’un certain recul sur ce sujet, ayant été tour à tour évalué et évaluateur à de nombreuses reprises, dans des contextes différents : HCERES, AERES, et pré-AERES (si, si ! il y avait déjà des évaluations de laboratoire avant l’AERES, au moins dans les UMR…)

Je développe dans ce billet l’argumentation suivante : l’évaluation de la recherche est indispensable, mais à mon avis pas nécessairement bien faite dans notre pays. Elle souffre notamment de défauts qui ne sont pas du fait ni des évalués, ni des évaluateurs, mais qui sont en partie une conséquence structurelle de l’organisation de la recherche française et de ses structures (UMR, EA, organismes, structures d’évaluation multiples…).

L’évaluation a mauvaise presse

Nous passons notre temps a faire des dossiers d’évaluation. C’est épuisant. On est évalué en permanence, pour tout : projets, équipes, personnes, laboratoires, diplômes, institutions…

Commentaire typique, fréquemment répété et entendu

C’est un leitmotiv traditionnel dans notre communauté. On est évalué tout le temps et pour tout, c’est chronophage et redondant. Ce commentaire est à mon avis la fois en partie vrai et en partie de mauvaise foi. Oui, nous sommes évalués très souvent (trop), et ça prend du temps, mais c’est aussi dans des dimensions très différentes et pour des objectifs variés. Les évaluations d’un manuscrit soumis pour publication, d’une demande de financement, d’un dossier de promotion individuel ou de la stratégie d’un laboratoire examinent des aspects très différents, avec des critères spécifiques à chacun : raisonnement scientifique, faisabilité, originalité, cohérence, encadrement, vision… Améliorer la cohérence et l’articulation de ces évaluations et réduire leur redondance est un vrai enjeu, mais je ne vois pas comment on pourra échapper à cette multiplicité. D’autant plus que l’évaluation par les pairs est vraiment consubstantielle à la démarche scientifique et que c’est une pratique quasi-universelle dans la communauté académique internationale.

Un autre sujet de friction sont les suites qui sont données à ces évaluations et leurs conséquences. Pour certains, elles sont intrusives, nuisibles à notre chère liberté académique, et en conséquence illégitimes. Pour d’autres, les conséquences sont au contraire quasi-inexistantes, sur le mode « pourquoi tant d’efforts, si à l’arrivée je n’ai pas plus de moyens pour ma recherche ». Je me rangerais plutôt dans cette deuxième catégorie. Et dans les deux cas, ça génère du mécontentement, même si c’est pour des raisons en partie opposées.

L’évaluation est pourtant utile et même indispensable

L’évaluation est selon moi utile a plusieurs niveaux :

Pour les évalués d’abord, c’est un moment rare d’introspection, de remise en cause, de réflexion sur l’avenir et de redéfinition de ses projets. J’ai toujours trouvé cette partie utile, même si elle est chronophage (c’est un peu comme corriger des copies : c’est souvent long et fastidieux, mais c’est un retour direct et précieux sur ce que les étudiants ont assimilé de notre enseignement). Pas mal de laboratoires organisent des « retraites » ou des séminaires internes/brainstorming pour préparer ces évaluations et réfléchir à leurs projets futurs. C’est un exercice qui s’avère souvent très riche.

C’est aussi un moment privilégié d’interaction directe avec des pairs, à savoir les membres du comité d’évaluation avec lesquels il est possible d’échanger de manière assez approfondie. Par construction, ce comité est constitué de collègues de la même discipline qui partagent les mêmes intérêts scientifiques. Ils sont là pour juste nous, ont en principe étudié le dossier, écoutent nos présentations, et sont de facto réceptifs à nos travaux. J’ai également trouvé que leur regard extérieur sur notre recherche et nos projets et les échanges qui s’ensuivent sont en général aussi très intéressants (pourvu que le comité soit raisonnablement bienveillant… mais ça a souvent été le cas dans mon expérience). Et ceci est vrai aussi quand on se retrouve à son tour dans la position symétrique de l’évaluateur, membre d’un comité d’évaluation.

L’évaluation est/devrait aussi être utile pour les responsables scientifiques en charge du laboratoire, à différents niveaux : le directeur du laboratoire lui-même, le VP recherche et la commission recherche de l’université, les directions scientifiques des instituts et d’organismes tutelles et leur instances d’évaluation internes. En principe, ils devraient s’en saisir pour faire de la prospective et de la veille scientifique, et aussi… pour leur politique d’allocation des moyens (un autre sujet qui fâche souvent). Mais cet aspect là marche beaucoup moins bien. La première raison perçue est qu’il n’y a pas véritablement de schéma incitatif en raison entre autres d’une vraie pénurie de moyens, ce qui est malheureusement le cas ces dernières années. Mais il y en a une autre : l’évaluation est à mon avis structurellement biaisée par l’organisation de notre système et ne permet de toute façon pas de donner aux parties prenantes une information fiable dont elles auraient besoin pour prendre des décisions. J’explique en dessous pourquoi.

Les structures de recherche en France

L’évaluation de la recherche par le HCERES s’appuie sur la structure de notre recherche et son organisation. Le HCERES applique l’évaluation à l’échelle de ces structures.

La « brique de base » de la recherche académique en France, c’est le laboratoire ou unité de recherche. L’unité de recherche peut être mixte entre plusieurs partenaires, en général entre une université et un organisme de recherche (CNRS, INSERM, INRAE…). Il y a aussi des unités de recherche propres des organismes comme des universités (non-mixtes, avec une seule tutelle). Le HCERES organise donc l’évaluation de chacune de ces briques élémentaires que sont les unités de recherche. D’après le dernier rapport du HCERES (disponible ici), il y a environ 2500 unités de recherche dans le système de recherche français.

Dans ces 2500 laboratoires, on trouve 55 000 enseignants-chercheurs relevant du ministère chargé de l’enseignement supérieur et 27 000 chercheurs des EPST : CNRS, INSERM, INRAE, INRIA, IRD… (données du ministère, ici et ici). Ça veut donc dire qu’une unité de recherche, ça regroupe en moyenne 30-35 chercheurs et enseignants-chercheurs permanents. A ceux-ci, il faut bien sûr aussi ajouter des techniciens et ingénieurs, et des contractuels (doctorants, post-doctorants…).

Mais cette donnée moyenne est très trompeuse. Car sous ce vocable « unité de recherche » se cachent des réalités très différentes, à la fois d’une discipline à l’autre, mais aussi à l’intérieur d’une même discipline. Une unité de recherche, ça peut en effet être un très grand institut, regroupant plusieurs centaines de personnes, ou une tout petite équipe, focalisée sur une thématique unique.

Dans les laboratoires de taille importante, il y a souvent une structuration interne en équipes (en particulier dans les disciplines expérimentales comme la mienne), voire un regroupement des équipes en plusieurs départements dans les plus grosses unités de recherche. Le LAAS, (laboratoire d’analyse et d’architecture des systèmes à Toulouse), par exemple, est l’un des plus gros laboratoires du CNRS et regroupe environ 600 personnes. Celles-ci sont réparties dans une trentaine d’équipes organisées en six départements. A l’autre extrémité du spectre, il y a de nombreux laboratoires mono-équipe : l’unité de recherche INSERM sur les arthrites auto-immunes de Marseille, par exemple, ne comporte que 11 personnes en tout, doctorants compris (source ici). La difficulté que je veux pointer, c’est que peu ou prou, notre système d’évaluation applique la même méthode générale pour l’évaluation d’entités extrêmement diverses et je pense que ça induit des distorsions et des inégalités de traitement.

Des laboratoires gros et petits…

Je me suis ensuite posé la question de la distribution de la taille des ces laboratoires : Est-ce que les très grosses unités de recherches sont des cas exceptionnels ? Y-a-t-il des spécificités disciplinaires, avec par exemple plutôt des gros labos en physique et plutôt des petits en SHS ? Ou des différences par type d’institution, avec des plus gros labos quand c’est mixte avec les organismes de recherche et des plus petits quand il s’agit d’équipes purement universitaires ?

J’ai eu du mal à aborder cette question, parce que je n’ai pas trouvé de données facilement et directement utilisables. Il y a bien le référentiel (liste) de toutes les unités de recherche en France sur le site data.gouv.fr, mais il n’y a pas les effectifs. Alors on les trouve sur le site du HCERES, dans le rapport d’évaluation publié pour chaque labo (un exemple dans la figure ci-dessus). Ça veut dire qu’il faut télécharger le rapport en PDF de chaque unité sur le site du HCERES, aller à la page « Effectifs » et extraire le nombre de statutaires et de contractuels pour chacun d’eux. J’ai bien pensé faire un petit script pour automatiser, mais la présentation de ces données n’est pas toujours homogène d’un rapport à l’autre et j’ai renoncé. J’ai opté pour la solution bête et méchante, se les palucher un par un (ça occupe, pendant les soirées de confinement…). Du coup, j’ai craqué et je n’ai pas fait tous les 2500 labos français, mais seulement deux sous-échantillons :

- Toutes les unités de recherche de l’INSERM, il y en a environ 270 (ça varie un peu d’une année sur l’autre). Ça m’intéresse parce que c’est ma discipline et que ça permet de voir la globalement la diversité au sein de l’ensemble d’un organisme (le CNRS, c’était trop gros pour une approche à la main).

- Toutes les unités de recherche d’une grande université de province, refusionnée, couvrant toutes les disciplines. Ça faisait un peu plus de 70 unités de recherche (une poignée étaient dans la première liste, puisque mixtes avec l’INSERM). Ça me permettait de couvrir toutes les disciplines cette fois-ci et aussi d’avoir des unités purement universitaires, non-mixtes.

Au total, ces deux échantillons représentent environ 330 unités de recherche distinctes, soit ~13% de tous les labos de notre pays, ce qui est tout de même conséquent.

Le graphe ci-dessous montre la distribution des tailles des laboratoires de recherche pour ces deux échantillons. En abscisse, l’effectif total du labo, et en ordonnée, le nombre de laboratoires dans chaque tranche d’effectif.

Je fais plusieurs observations sur ces deux distributions :

- Elles sont remarquablement similaires, ce qui suggère que c’est quelque chose de représentatif de l’ensemble du dispositif national ;

- Dans les deux cas, il y a un pic de distribution autour des labos de 20-40 personnes (tout compris) qui sont nombreux, mais aussi une grande « queue-de-distribution » vers la droite avec un nombre significatif de gros instituts (>100 personnes). En effectifs consolidés, cette queue de distribution représente du monde, justement parce qu’il s’agit de gros labos (en effectif, un labo de 600 personnes = vingt labos de 30 personnes) ;

- Dans l’université étudiée, les gros laboratoires (effectifs>100 personnes) sont tous des unités mixtes avec les organismes de recherche. Probablement parce que le statut d’UMR est attractif et que les universités cherchent à y caser le plus possible de leurs ouailles auxquelles s’additionnent de surcroit les personnels CNRS, INSERM… ;

- Il n’y a pas d’effet disciplinaire net, il y a des gros et des petits laboratoires dans toutes les disciplines (avec la limite que l’échantillon universitaire que j’ai utilisé n’est pas très grand).

La distribution des tailles ressemble un peu à une distribution log-normale, mais avec une queue de distribution plus importante.

Les problèmes de l’évaluation « one-size-fits-all »

Le HCERES applique la même procédure d’évaluation à toutes les unités de recherche quelle que soit leur taille : un comité d’expert avec un président, effectuant une visite sur site, donnant lieu à un rapport d’évaluation. Certes, quand l’unité est de taille importante, le comité est en général plus étoffé et le rapport plus épais, mais on reste dans le même principe général. C’est une application sans fioritures du 2° de l’article L114-3-1 du code de la recherche (pour faire court, cet article dit que, entre autres, le HCERES est chargé d’organiser l’évaluation des unités de recherche).

Comme il y a ~2500 unités de recherche dans notre pays qui sont évaluées sur un cycle de cinq ans, ça signifie que le HCERES doit organiser chaque année au moins 500 évaluations, ce qui est une énorme machine. On peut s’interroger sur l’efficacité de cette grosse usine, du fait de l’asymétrie de la distribution de taille des laboratoires évoquée plus haut.

La médiane de taille des unités de recherche sur mes deux échantillons est située autour d’un effectif total de 42 personnes (tout compris). Ça veut dire que la moitié des comités d’évaluation organisés concerne des unités de 42 personnes ou moins et l’autre moitié des unités de plus de 42 personnes. Mais si on raisonne en termes d’effectifs consolidés, la seconde catégorie représente environ cinq fois plus de personnes. Parce que justement, les unités de recherche qui la composent sont plus grosses et même parfois beaucoup plus grosses.

Dit autrement, le HCERES consacre une moitié des comités qu’il organise à évaluer seulement 16 % des scientifiques de notre pays, et l’autre moitié à évaluer les 84 % restants.

On pourrait se dire que ça n’est pas si grave et que c’est un modeste prix à payer en contrepartie d’une certaine « biodiversité » de notre écosystème de recherche. Mais je soutiens la thèse que ça a d’autres conséquences problématiques :

- Ça a un coût financier. Ce n’est pas le problème le plus critique à mon sens, mais à argent public constant, on peut se demander si une approche différente ne pourrait pas donner quelque chose de meilleure qualité et de plus utile pour tout les acteurs (évalués, direction du labo, tutelles, instances d’évaluation).

- Sous une apparence d’équité, les standards d’évaluation des grandes unités et des petites unités peuvent en réalité être assez différents. Il sont potentiellement plus exigeants pour les grands instituts que pour les petites structures. C’est un point un peu polémique que je développe plus bas

- L’évaluation est en partie émiettée sur une flopée de petites unités, avec chacune leur comité individuel travaillant en silo, ça empêche d’avoir une vision globale de la recherche dans un domaine donné sur un site précis. Ce qui serait pourtant très utile pour définir des stratégies et des politiques scientifiques.

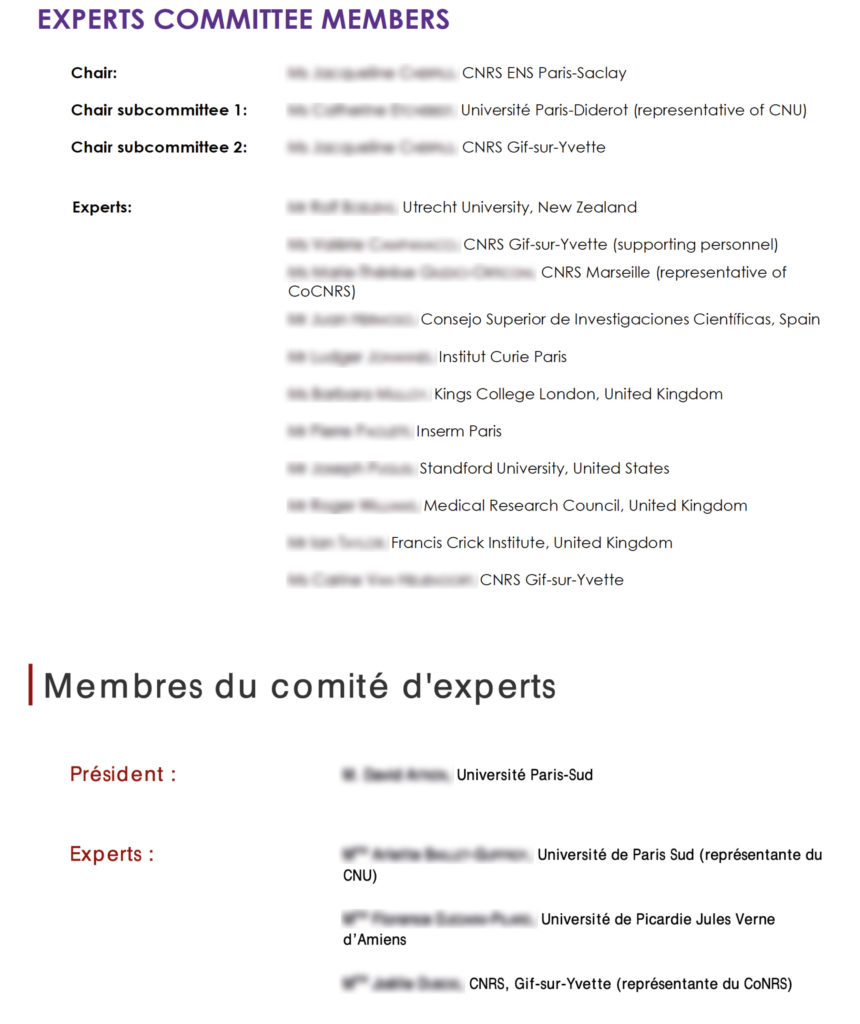

Je reviens sur la question du standard d’évaluation. Lorsqu’on regarde la composition des comités d’évaluation des grands instituts, on constate fréquemment qu’ils comportent une proportion significative de collègues étrangers, issus d’institutions ou de laboratoires prestigieux. Cette proportion est en général plus faible, voire parfois inexistante dans les comités d’évaluation des petites équipes.

Sans aucunement remettre en question l’indépendance et l’intégrité des deux groupes d’experts, je ne suis pas persuadé que le standard d’évaluation de ces deux comités ait été identique…

Mon interprétation est la suivante : il est plus facile de faire venir des collègues étrangers de haut-niveau pour évaluer un grand laboratoire français très connu que pour une petite structure moins visible à l’international. Et c’est probablement aussi une affaire de coût pour le HCERES, notamment de frais de mission quand les experts viennent de loin. Alors certainement la taille n’est pas tout, et il existe probablement des contre-exemples avec des petits labos très réputés à l’international et des gros moins performants. Mais les grands instituts ont fréquemment un historique, une identité, une renommée qui contribue à permettre de mobiliser des comités d’évaluation de très haut niveau. Et, pour l’avoir vécu de l’intérieur comme évaluateur, ces comités de haut niveau appliquent un standard d’évaluation sensiblement plus exigeant. C’est à mon avis positif pour ces grands instituts, parce que ça les incite à progresser et à se mesurer aux standards de nos grands voisins scientifiques. Par contre, si on regarde l’ensemble de ce que réalise le HCERES, il résulte de cette diversité des unités de recherche une hétérogénéité importante dans le standard d’évaluation appliqué. Ceci est préjudiciable au processus qu’il décrédibilise en partie, et rend hasardeux toute consolidation des expertises des différents labos à l’échelle d’une université, d’un site ou d’une discipline.

Quelle granularité pour l’évaluation de la recherche ?

Le grain de l’évaluation est aussi un sujet de débat inépuisable dans la communauté. Le problème que j’évoquais plus haut, c’est que « l’unité de recherche », c’est un grain très très variable (entre les extrêmes, ça varie de 1 à 50 en taille…). Une solution ne serait-elle pas d’essayer de réduire cette hétérogénéité de grain ? Comme chez beaucoup de nos voisins où la recherche est souvent évaluée à l’échelle des departments des universités. Globalement. Par discipline. Un objectif similaire chez nous pourrait être faire des comités d’évaluation communs à un ensemble de petits labos de la même discipline, quand c’est possible (je sais, il y a des sites/disciplines où ça sera compliqué, mais on peut certainement faire mieux qu’aujourd’hui).

Petite simulation sur un coin de table : imaginons qu’on se fixe un seuil cible à minimum ~50-100 chercheurs, enseignants-chercheurs et ingénieurs de recherche pour un comité (éventuellement commun à plusieurs unités de recherche pour atteindre le seuil). Première conséquence, on réduit le nombre de comités, donc la logistique : ~200 par an au lieu de 500 (et aussi le nombre de rapports et le temps passé). Deuxième conséquence, avec les moyens financiers dégagés, on peut faire des comités plus étoffés, de bon niveau, avec davantage d’experts étrangers. Troisième conséquence, ces comités étant plus standardisés, on pourrait espérer avoir des évaluations plus homogènes entre elles. Je suis sûr que des universités, des organismes et leurs propres instances d’évaluation seraient preneuses. Et ça éviterait que certaines institutions refassent tout le boulot d’évaluation en double derrière le HCERES, parce qu’elles estiment que le résultat global ne leur convient pas.

Je vois bien les critiques possibles : « À l’université Machin, en pataphysique moléculaire, il n’y a qu’un seul labo, impossible de regrouper avec d’autres » ou « Avoir le même comité pour le labo Tartemuche et le labo Macheprot ! mais vous n’y pensez pas, ils se détestent et ne se sont pas parlé depuis 10 ans… ». Mais je persiste à penser que ça vaudrait la peine de regarder ce qui est faisable et d’expérimenter sur certains sites, ce que les textes régissant l’évaluation et le HCERES permettent.